Skalowanie systemów w chmurze. Bezpłatny webinar i najlepsze praktyki w zakresie optymalizacji

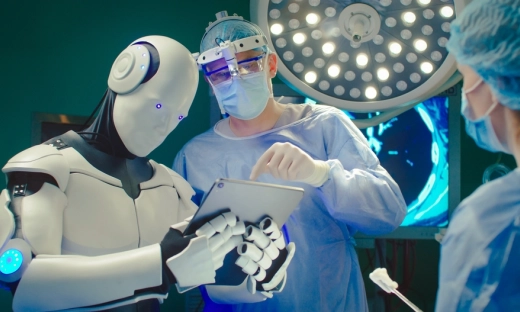

Sztuczna inteligencja i uczenie maszynowe już nie są zarezerwowane jedynie dla laboratoriów badawczych czy globalnych gigantów technologicznych. W sektorach Medtech i Mediatech stają się codziennym narzędziem do diagnozowania, podejmowania decyzji, rekomendowania treści i optymalizacji operacji. Zgodnie z raportem Cloud-Driven Medtech & Mediatech 2025, dobrze zaprojektowane wdrożenia AI/ML w chmurze mogą skrócić czas dostarczania diagnozy o 30–40%, zmniejszyć koszty infrastruktury nawet o 60% i radykalnie poprawić dostępność usług.

9 sierpnia o godzinie 15:00 | Bezpłatny webinar

Skalowanie systemów w chmurze: najlepsze praktyki w zakresie optymalizacji wydajności i kosztów

Inteligentne skalowanie = szybkość, wydajność i oszczędność. Eksperci wystartowali z serią webinarów, która powoli dobiega końca. Dlatego zapraszamy Was na ostatni już webinar!

Neoncube, Jacek Nosal, Radpoint i Michał Smoliński odpowiedzą na pytanie: Czy inwestycja w chmurę się opłaca oraz jak skalować mądrze, by nie stracić?

Dowiedz się, jak:

- Efektywnie skalować przy użyciu Kubernetes i autoskalowania

- Unikać pułapek związanych z kosztami chmury

- Budować MVP gotowe do dalszego rozwoju

- Obsługiwać systemy o dużym natężeniu ruchu i wysokim ryzyku

Chmura jako przestrzeń do rozwoju inteligentnych modeli

Według Neoncube, chmura – zwłaszcza w modelu serverless lub PaaS – to dziś najlepsze środowisko do trenowania i wdrażania modeli AI. Dzięki usługom takim jak AWS SageMaker, firmy mogą trenować modele w rozproszonych środowiskach, skalować je dynamicznie, korzystać z gotowych algorytmów i przyspieszyć iterację – bez konieczności inwestowania w kosztowną infrastrukturę lokalną.

Co więcej, platformy te wspierają eksperymenty low-code, automatyzują walidację modeli i umożliwiają ich monitoring w czasie rzeczywistym, co ma kluczowe znaczenie w środowiskach o wysokiej odpowiedzialności – takich jak medycyna czy media cyfrowe.

Diagnostyka i personalizacja. Konkretne przypadki użycia

W obszarze Medtech sztuczna inteligencja coraz częściej wspomaga lekarzy w analizie obrazów medycznych (np. z endoskopii kapsułkowej), rozpoznawaniu wzorców w badaniach diagnostycznych i monitorowaniu stanu pacjentów. Jak pokazuje case study Radpoint z raportu, wykorzystanie AI w chmurze pozwoliło skrócić czas przetwarzania danych diagnostycznych z kilku godzin do 15 minut.

W sektorze Mediatech natomiast, algorytmy NLP i duże modele językowe (LLM) wspierają dynamiczne kierowanie treściami, moderację komentarzy, transkrypcję materiałów oraz rekomendacje w czasie rzeczywistym. Dzięki temu platformy streamingowe mogą personalizować doświadczenia użytkowników na niespotykaną wcześniej skalę.

Etyka, explainability i zaufanie do algorytmów

Jednym z kluczowych tematów poruszanych w raporcie Neoncube jest wyjaśnialność modeli AI (explainability) oraz etyczne podejście do danych. W projektach medycznych, ale i w rozrywce, zaufanie użytkownika do działania algorytmu staje się czynnikiem krytycznym.

Dlatego firmy wdrażające AI powinny dbać o przejrzystość decyzji podejmowanych przez modele, kontrolę nad danymi treningowymi oraz zgodność z regulacjami (np. RODO, MDR, eIDAS 2.0). Jak zatem wdrażać rozwiązania cloudowe w integracji z AI/ML?

To nie tylko inspiracja – to konkretne wskazówki dla decydentów, którzy chcą wdrażać AI w sposób odpowiedzialny, efektywny i skalowalny.